模块五-微博评论高性能高可用计算架构

架构分析

用户量

2020.9月月活5.11亿,日活2.24亿(参考《微博2020用户发展报告》)。

行为建模

发评论

假设平均每人每天发1条微博

假设1条微博平均观看有100次,评论数量就有10次

假设每条微博被观看10次就会收到1条评论

假设发评论和看微博的时间段基本一致:

60%在早上8:00~9:00点,中午12:00~13:00,晚上20:00~22:00

看评论

假设看评论的次数和看微博的次数一致

假设平均一条微博观看人数有100次

假设看微博的时间段和发微博的时间段基本重合

性能需求分析

发评论

业务特性分析

发评论是一个典型的写操作,因此不能用缓存,可以用负载均衡。

架构分析

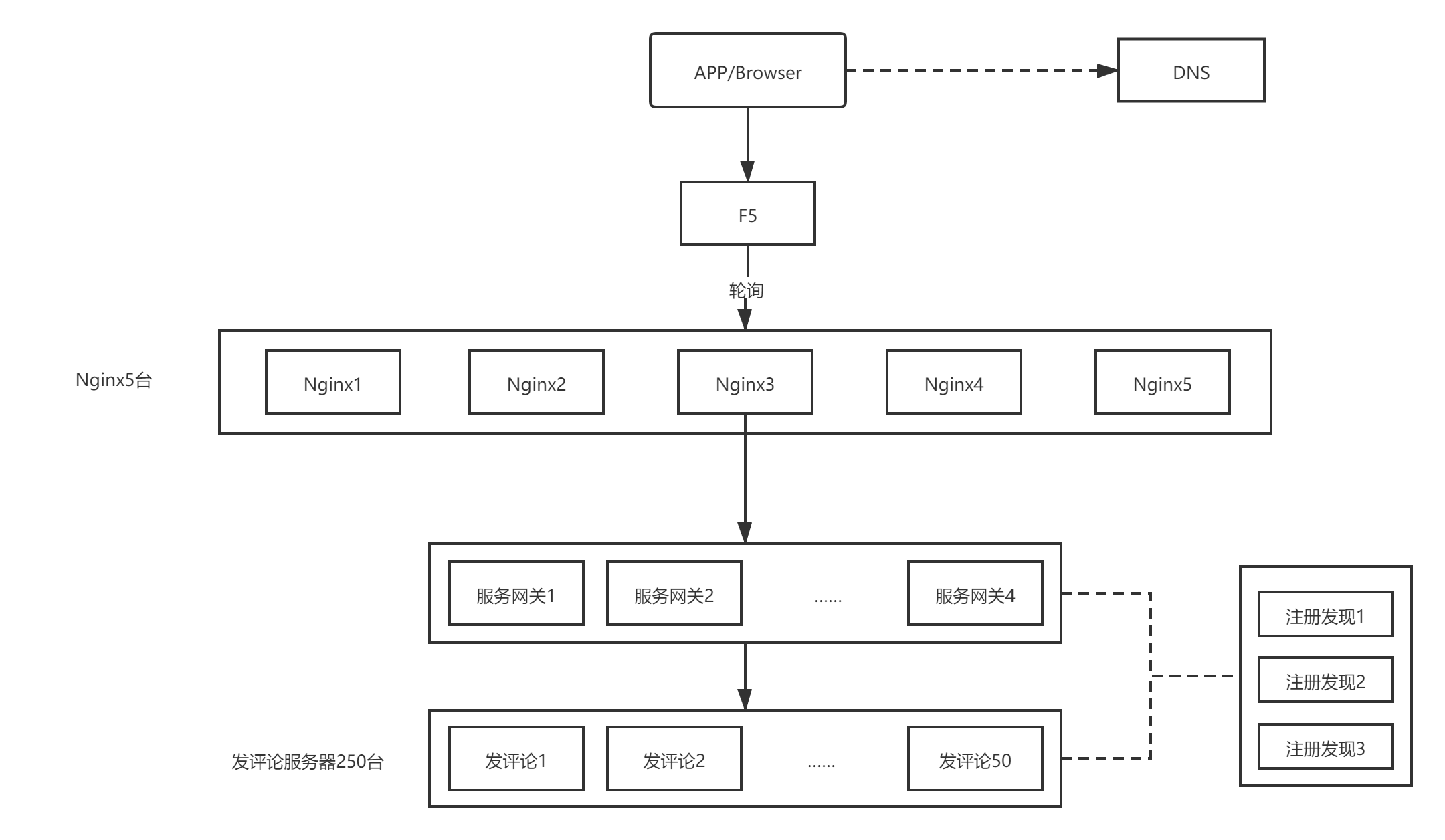

用户量过亿,应该要用多级负载均衡架构,覆盖 DNS->F5->Nginx->网关的多级负载均衡。

架构设计

负载均衡算法

选择发评论的时候依赖登录状态,登录状态一般都是保存在分布式缓存中的,因此发微博的时候,将请求发送给任意服务器都可以,这里选择“轮询”或者“随机”算法。

业务服务器数量估算

发评论涉及几个关键的处理

内容审核(依赖审核系统)、数据写入存储(依赖存储系统)、数据写入缓存(依赖缓存系统),因此按照一个服务每秒处理500来估算,完成100K/s的 TPS,需要200台服务器,加上一定的预留量,250台服务器差不多了。

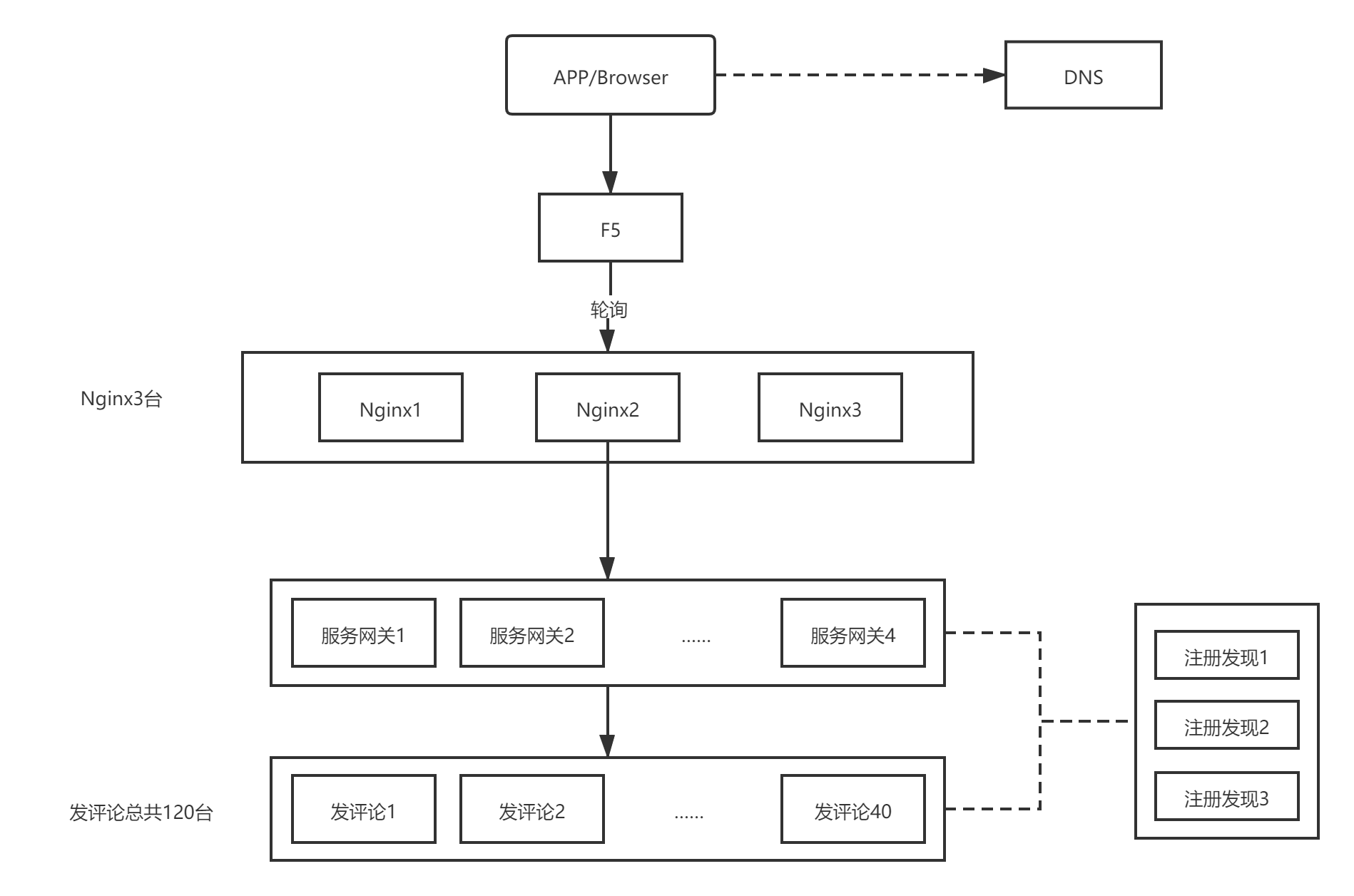

看评论

业务特性分析

一个典型的读场景

评论发布后不能修改

单条数据量小,但访问量大

架构分析

用户量过亿,应该要用多级负载均衡架构

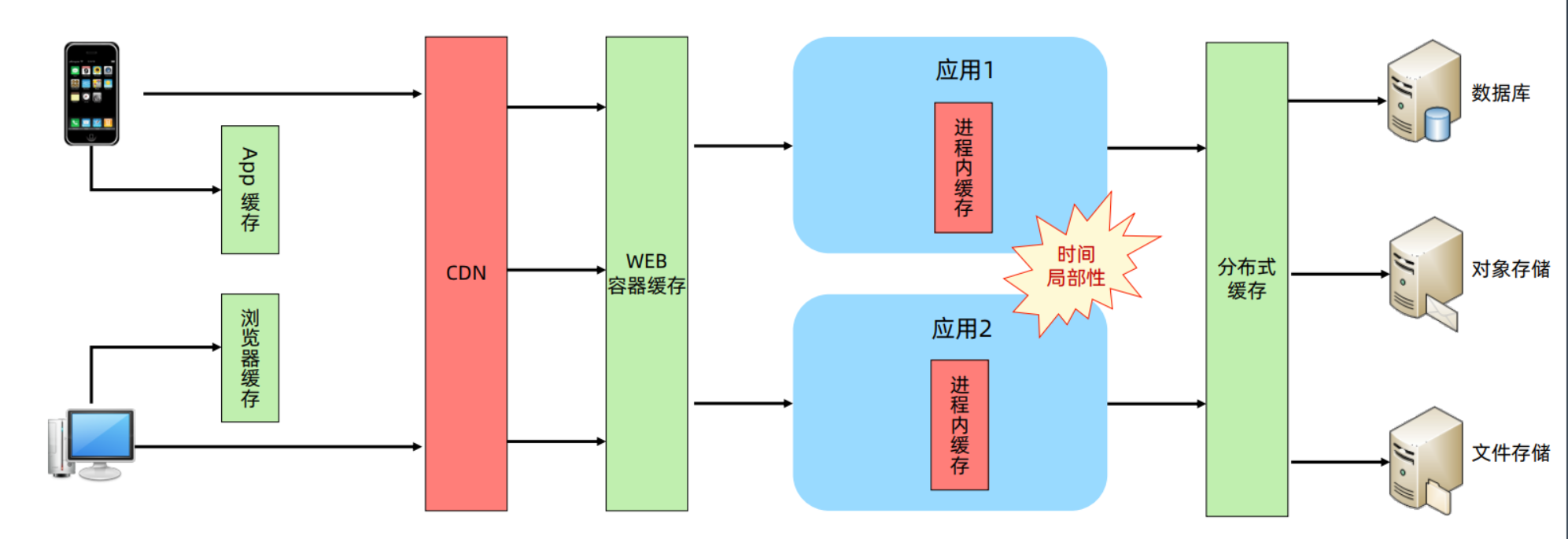

QPS大于100万,应该要用多级缓存架构,尤其是CDN缓存,是缓存设计的核心。

架构设计

负载均衡算法选择

游客都可以直接看微博,因此将请求发送给任意服务器都可以,这里选择“轮询”或者“随机”算法。

业务服务器数量估算

假设 CDN 能够承载90%的用户流量,那么剩下10%的读微博的请求进入系统,则请求 QPS 为1000K/s * 10% = 100K/s

由于读取微博的处理逻辑比较简单,主要是读缓存系统,因此假设单台业务服务器处理能力是1000/s,则机器数量为100台,按照20%的预留量,最终机器数量为120台。

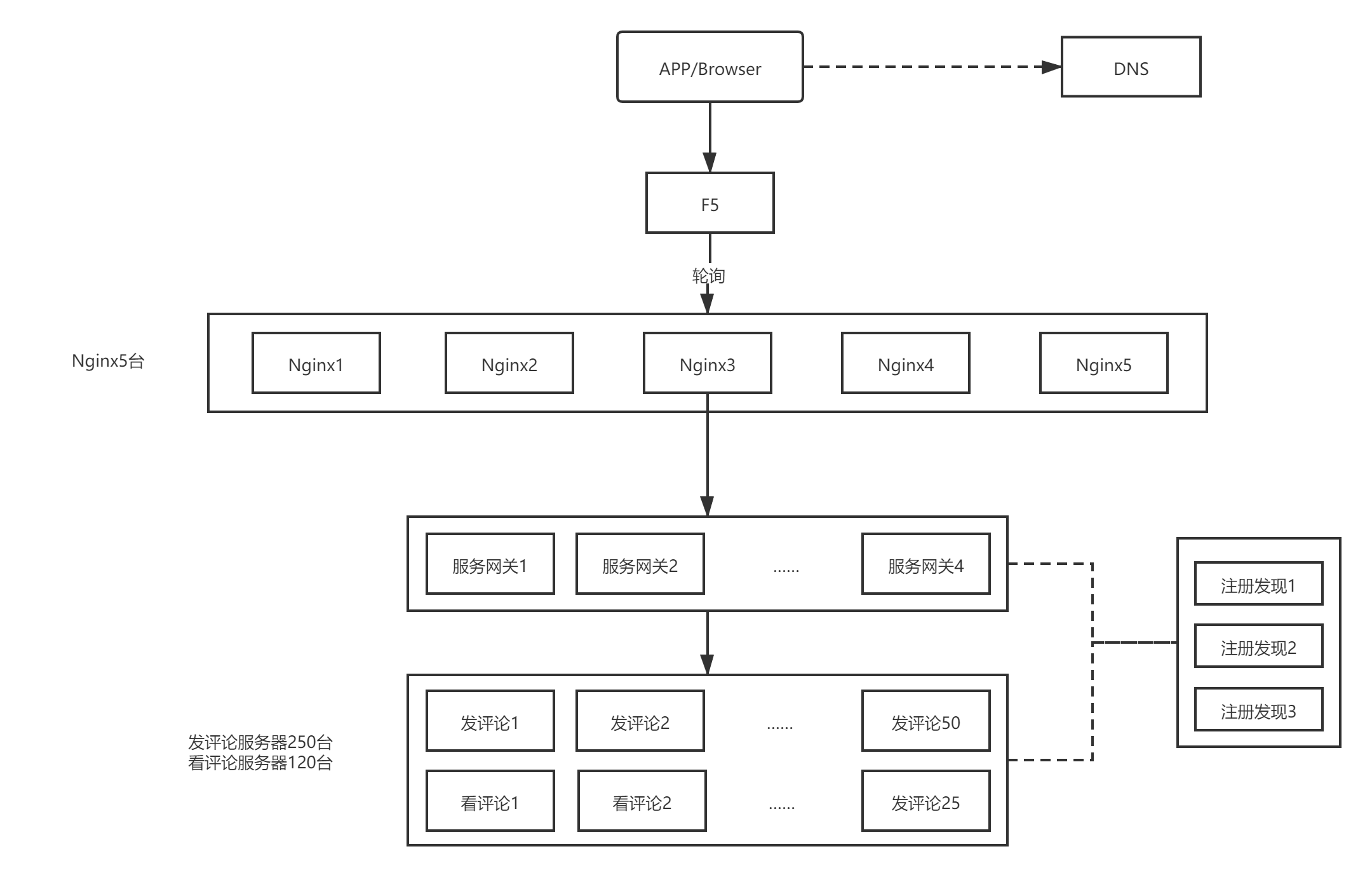

高性能高可用计算架构设计

发评论

负载均衡架构

看评论

负载均衡架构

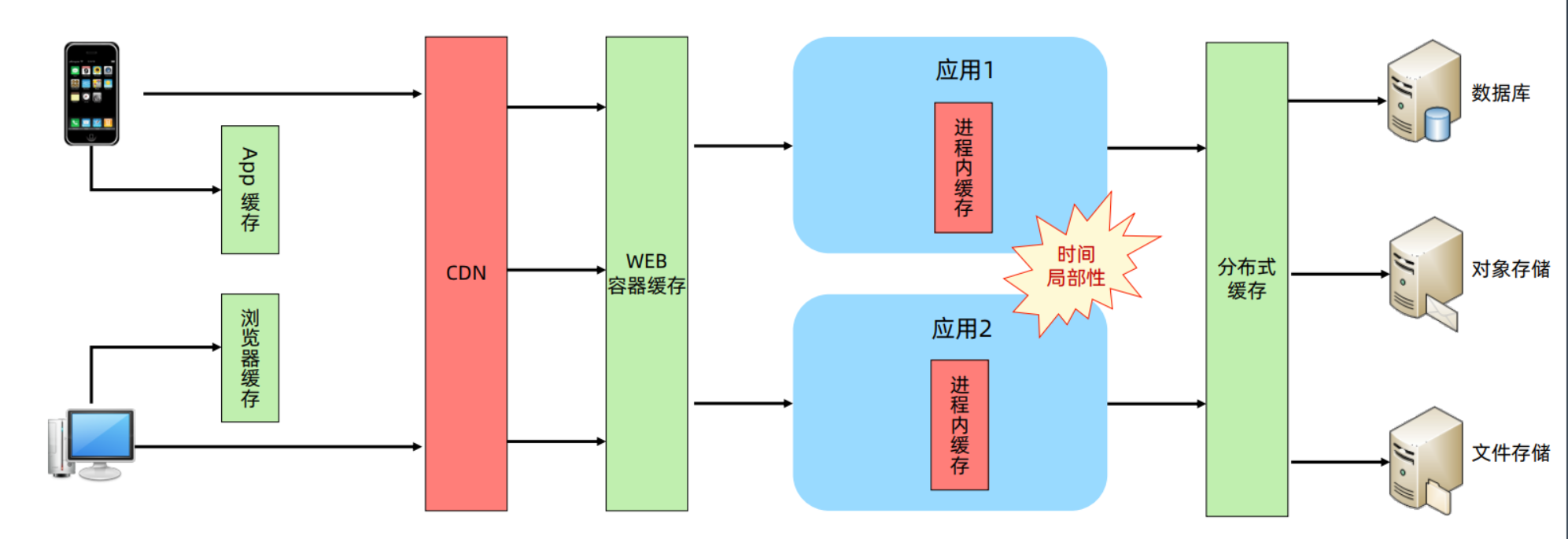

缓存架构

总体架构

负载均衡架构

缓存架构

附件

微博2020用户发展报告

https://data.weibo.com/report/reportDetail?id=456